Как установить и запустить LLM локально на телефонах Android

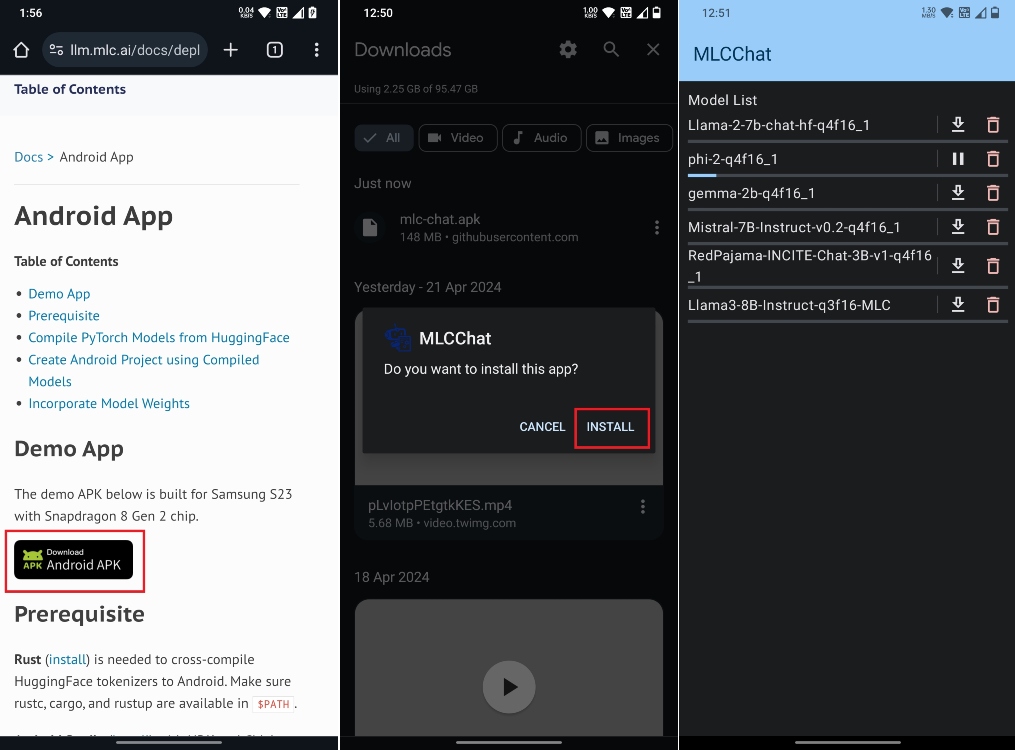

Хотя существуют такие приложения, как LM Studio и GPT4All, для локального запуска моделей искусственного интеллекта на компьютерах, на телефонах Android таких возможностей не так много. Тем не менее, компания MLC LLM разработала приложение для Android под названием MLC Chat, которое позволяет загружать и запускать модели LLM локально на устройствах Android. Вы можете загрузить небольшие модели искусственного интеллекта (от 2B до 8B), такие как Llama 3, Gemma, Phi-2, Mistral и другие. С этой ноты и начнем.

Примечание. В настоящее время MLC Chat не использует встроенный в устройство NPU на всех устройствах Snapdragon, поэтому генерация токенов происходит в основном медленно. Вывод делается только на процессоре. Некоторые устройства, такие как Samsung Galaxy S23 Ultra (на базе процессора Snapdragon 8 Gen 2), оптимизированы для работы с приложением MLC Chat, поэтому вам будет удобнее общаться.

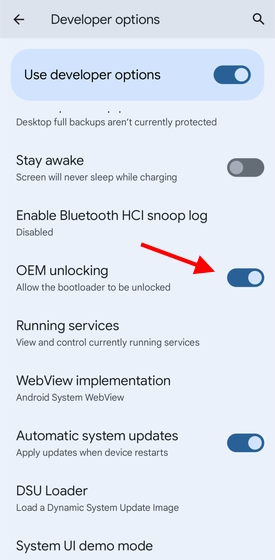

- Загрузите приложение MLC Chat (Бесплатно) для телефонов Android. Вам нужно будет скачать APK-файл (148 МБ) и установить его.

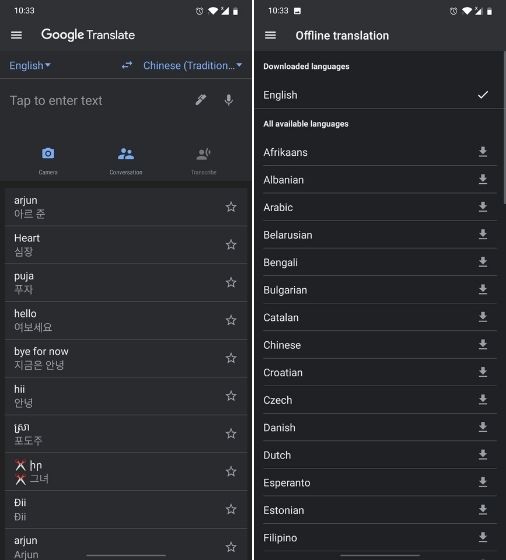

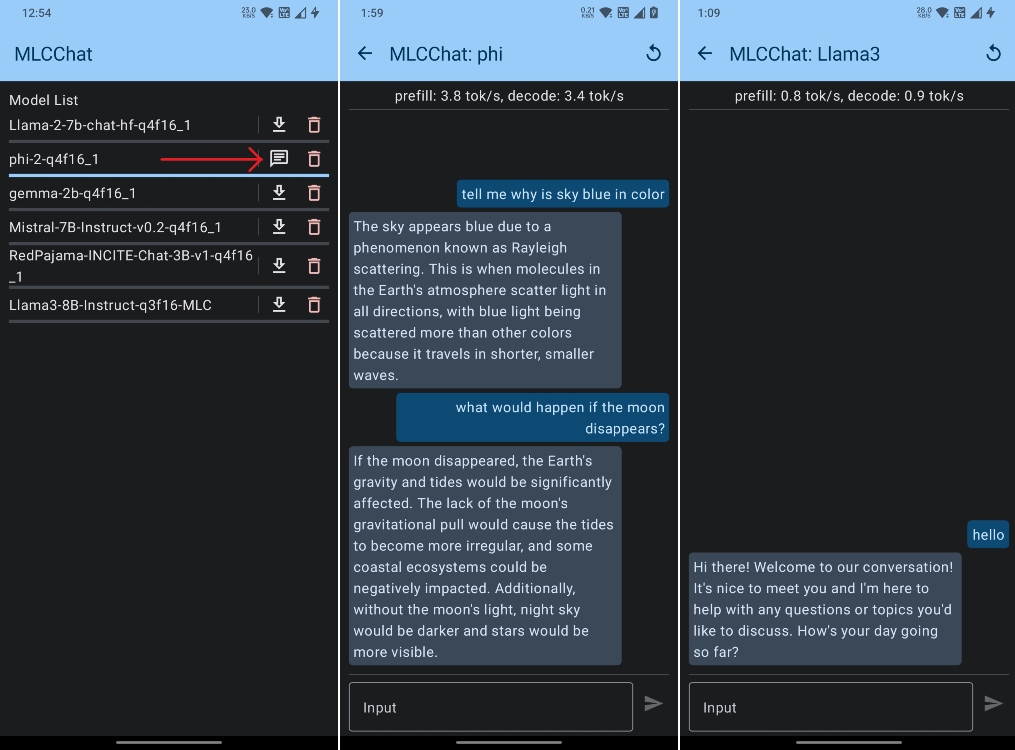

- Затем запустите приложение MLC Chat, и вы увидите список моделей AI. Он поддерживает даже последнюю модель Llama 3 8B, а также есть такие варианты, как Phi-2, Gemma 2B и Mistral 7B.

- Я скачал модель Phi-2 от Microsoft, поскольку она маленькая и легкая.

- После загрузки модели нажмите кнопку чата рядом с моделью.

- Теперь вы можете начать общаться с моделью ИИ локально на своем телефоне Android. Вам даже не нужно подключение к Интернету.

- Во время тестирования Phi-2 на моем телефоне работал нормально, но были некоторые галлюцинации. Джемма отказалась бежать. А Лама 3 8Б была слишком медленной.

Программы для Windows, мобильные приложения, игры - ВСЁ БЕСПЛАТНО, в нашем закрытом телеграмм канале - Подписывайтесь:)

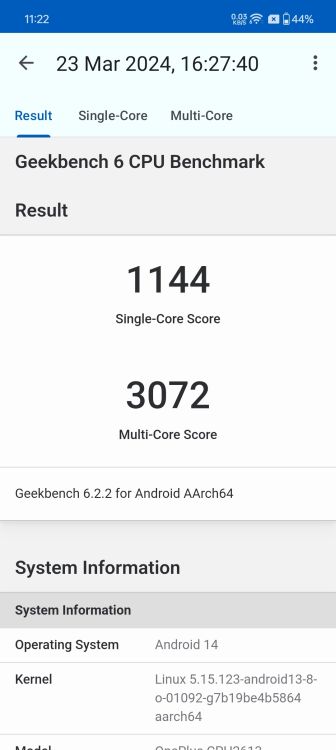

- На моем OnePlus 7T, оснащенном процессором Snapdragon 855+ SoC, чипом пятилетней давности, он генерировал выходные данные со скоростью 3 токена в секунду при работе Phi-2.

Вот как вы можете загружать и запускать модели LLM локально на своем устройстве Android. Конечно, генерация токенов идет медленно, но это показывает, что теперь вы можете запускать модели искусственного интеллекта локально на своем телефоне Android. В настоящее время он использует только ЦП, но благодаря реализации Qualcomm AI Stack устройства Android на базе Snapdragon могут использовать выделенный NPU, GPU и CPU, чтобы обеспечить гораздо лучшую производительность.

Рекомендуемые статьи

Как загрузить и запустить модель Google Gemma AI на ПК и Mac

Арджун Ша 7 марта 2024 г.

Как использовать Google Gemini для обобщения видео на YouTube

Сагник Дас Гупта 5 апреля 2024 г.

Со стороны Apple разработчики уже используют Платформа MLX для быстрого локального вывода на iPhone. Он генерирует около 8 токенов в секунду. Так что ожидайте, что устройства Android также получат поддержку встроенного NPU и обеспечат отличную производительность. Кстати, сама Qualcomm утверждает, что Snapdragon 8 Gen 2 может генерировать 8,48 жетонов в секунду при работе с более крупной моделью 7B. На квантовой модели 2B он будет работать еще лучше.

В любом случае, это все от нас. Если вы хотите общаться со своими документами, используя локальную модель искусственного интеллекта, прочтите нашу специальную статью. И если у вас возникнут какие-либо проблемы, сообщите нам об этом в разделе комментариев ниже.